Disallow: /?m=1

Disallow: /?m=0

Disallow: /*?m=1

Disallow: /*?m=0

Jika Anda memakai beberapa parameter tersebut dalam robots.txt, maka apakah Anda sudah paham betul maksud dari penggunaannya dan apakah juga telah mengetahui secara persis akibat yang dapat ditimbulkan?

Atas dasar beberapa alasan yang berhubungan dengan SEO, termasuk diantaranya yaitu untuk menghindari terjadinya duplicate content, memang ada sebagian blogger yang merekomendasikan penggunaan beberapa parameter tersebut dalam robots.txt blog. Namun tahukah Anda bahwa untuk menghindari terjadinya duplicate content semestinya tidak harus dilakukan dengan cara yang seperti itu. Hal ini disebabkan karena cara tersebut sebenarnya terbilang keliru dan bahkan sangat tidak dianjurkan oleh Google.

“Google does not recommend blocking crawler access to duplicate content on your website, whether with a robots.txt file or other methods. If search engines can't crawl pages with duplicate content, they can't automatically detect that these URLs point to the same content and will therefore effectively have to treat them as separate, unique pages. A better solution is to allow search engines to crawl these URLs, but mark them as duplicates by using the rel="canonical" link element, the URL parameter handling tool, or 301 redirects. In cases where duplicate content leads to us crawling too much of your website, you can also adjust the crawl rate setting in Webmaster Tools.” Sumber: Webmaster Tools Help

Berdasarkan kutipan tersebut dapat diketahui bahwa Google sendiri tidak merekomendasikan pemblokiran akses perayap untuk konten duplikat yang terdapat pada sebuah situs, baik dengan memakai robots.txt maupun metode yang lainnya. Hal ini disebabkan karena jika akses perayap dibatasi maka mesin pencari pun tidak dapat menjelajah halaman dengan konten duplikat, sehingga secara otomatis tidak dapat mendeteksi URL yang mengarah ke konten yang sama.

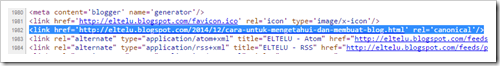

Solusi terbaik untuk mengatasinya yaitu dengan menggunakan rel=”canonical” pada elemen link. Sementara itu jika Anda adalah pengguna Blogger, maka tidak perlu bingung tentang penggunaan rel=”canonical” pada elemen link karena Blogger secara otomatis akan menambahkannya pada tiap link artikel dan blog Anda, seperti yang tampak pada gambar berikut ini.

Disamping tidak direkomendasikan oleh Google, membatasi akses perayap dengan memakai beberapa parameter tersebut di atas juga dapat menimbulkan akibat lain, yaitu tidak adanya indeks untuk laman seluler. Perlu diingat karena Google melakukan perayapan yang berbeda antara laman desktop dan seluler, maka jika beberapa parameter tersebut dimasukkan dalam robots.txt sama artinya dengan tidak memperbolehkan crawler untuk merayapi laman seluler guna melakukan pengindeksan.

Akibat lain yang ditimbulkan yaitu situs akan dianggap tidak Mobile-friendly. Hal ini disebabkan karena agar sebuah situs dapat dianggap mobile-friendly maka situs yang dimaksud harus memenuhi beberapa kriteria yang dipersyaratkan, termasuk diantaranya yaitu tidak adanya pelarangan akses crawler untuk melakukan perayapan terhadap laman seluler. Selengkapnya silakan klik di sini untuk mengetahui dan membuat blog Anda agar menjadi mobile-friendly.

Jadi apabila selama ini Anda memasang dan atau menggunakan beberapa parameter tersebut di atas, maka ada baiknya bila dilakukan peninjauan dan pengujian ulang terhadap robots.txt blog Anda. Sementara itu untuk mengetahui spesifikasi tentang robots.txt secara lebih detail dapat Anda pelajari pada Webmasters Google.

18 Desember 2014

18 Desember 2014

Terdapat 5 komentar pada artikel ini ▶

bener nih gara2 pke txt kode

Disallow: /?m=1

Disallow: /?m=0

Disallow: /*?m=1

Disallow: /*?m=0

jdi keblokir konten saya pas dicek https://www.google.com/webmasters/tools/mobile-friendly/ soalnya gk mobile friendly pdhl skrg uda byk org yg search artikel lewat mobile. jdi hati hati klo pke kode robot.txt harus tau fungsi kode itu buat apa.

salam blogger

azantie.blogspot.com

@yenny azantie Betul sekali Sob. Mengubah setelan pada robots.txt memang harus dilakukan secara cermat, benar, dan hati-hati agar tidak berakibat fatal terhadap pengindeks-an artikel yang diterbitkan. Salam.

Terima kasih penjelasannya, karena saya seting robot.txt seperti itu, saat saya cek mobile frendly dan tak ada, sitemap yang harusnya lebih dr 100 post hanya terindek 26 -_-

@MZ Nasrul Sama-sama Sobat.Dan kalau begitu tidak ada salahnya bila segera dilakukan pembenahan.

Setuju, apalagi newbie seperti saya min, harus lebih memahami lagi tentang yang beginian